EnhancedProgramDevelopment › MsMailMerge › GuitarLessons › ComputerAnimation › LocalKeywords/FindPage › AbsoluteValueOfDeviationScore

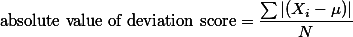

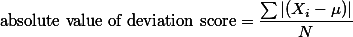

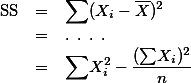

왜 차이값을 (deviation score) 제곱하여 더한 값의 평균 (즉, 분산 Variance) 을 사용하나요? 차이값의 절대값을 더한 값의 평균을 사용하는 것이 더 직관적이지 않나요?

- 우선, raw data에서 분산값을 계산하기가 쉽다.

See http://wiki.commres.org/ANOVA#s-2.2

See http://wiki.commres.org/ANOVA#s-2.2

- 실제로 Mean absolute deviation (MAD) 으로 사용되고 있기도 하다. see

Average Absolute Deviation

Average Absolute Deviation

- See

![[http]](/imgs/http.png) Cross Validated에서 나온 질문과 답

Cross Validated에서 나온 질문과 답